Unternehmen holen LLMs aus dem Experimentierlabor in den produktiven Alltag: Copilots unterstützen Fachabteilungen, KI-Services beschleunigen Workflows, ganze Kundenportale laufen auf generativen Modellen. Spätestens dann wird eine zentrale Frage strategisch: Läuft dein LLM auf eigenen, privaten Servern in der Private Cloud – oder beziehst du es über öffentliche Cloud-APIs wie OpenAI, Azure OpenAI oder ähnliche Anbieter. In diesem Beitrag erhältst du einen klaren Überblick, wie LLM Server Hosting funktioniert, worin sich private LLM-Server und öffentliche LLM-APIs unterscheiden und welches Modell zu den Anforderungen deines Unternehmens passt.

Was ist LLM Server Hosting?

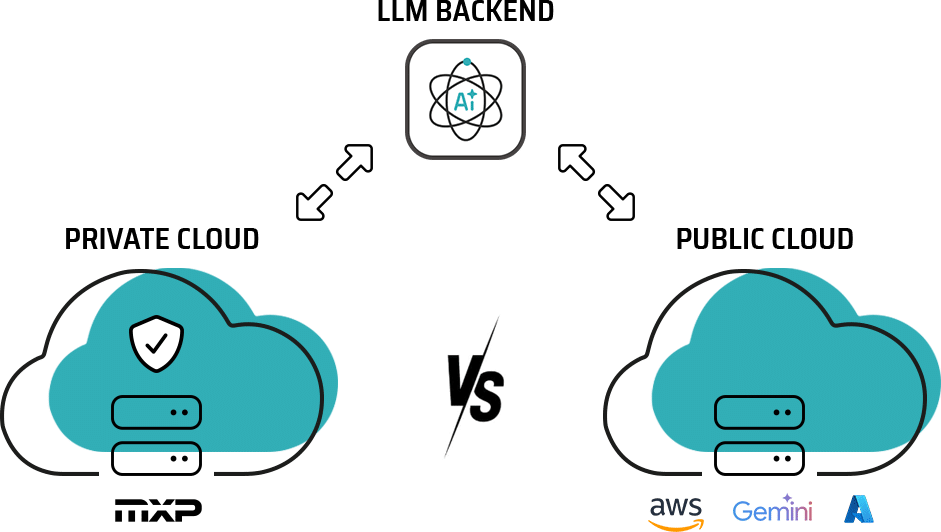

LLM Server Hosting beschreibt den professionellen Betrieb eines Sprachmodells auf Servern, die gezielt für diesen Zweck bereitgestellt und überwacht werden. Im Zentrum steht dabei das LLM-Backend: Es nimmt Anfragen deiner Anwendungen, Dienste oder Fachsysteme über eine definierte API entgegen, verarbeitet sie mit dem Modell und liefert strukturierte Antworten zurück. Je nach Strategie betreibst du dieses LLM-Backend entweder auf privaten Servern in einer Private Cloud oder du greifst auf LLM-Server zurück, die dir über öffentliche Cloud-APIs als Dienst zur Verfügung gestellt werden.

Vergleich: Private Cloud vs. öffentliche Cloud-APIs

| Aspekt | LLM-Server in der Private Cloud | LLM Server über öffentliche Cloud-APIs |

|---|---|---|

| Betriebsmodell | Dedizierte LLM-Server in Private Cloud oder Rechenzentrum, auf Wunsch Single-Tenant mit strikter Mandantentrennung | Vom Anbieter betriebener, global erreichbarer API-Service, meist Multi-Tenant mit geteilten Ressourcen |

| Daten & Compliance | Verarbeitung in kontrollierter Umgebung; gezielte Umsetzung der Anforderungen aus DSGVO, EU AI Act und branchenspezifischen Regularien | Datenverarbeitung in der Infrastruktur des Providers; Datenhoheit und -residenz abhängig von Angeboten und Vertragsklauseln des Anbieters |

| Kontrolle & Anpassung | Freie Modellwahl (z.B. LLaMA, Mistral, DeepSeek), Fine-Tuning und Governance nach internen Security- und Compliance-Vorgaben | Standardisierte Modellpaletten mit begrenzten Eingriffsmöglichkeiten; Policies, Features und Roadmap abhängig von der Strategie des Providers |

| Kostenmodell | Planbare Infrastrukturkosten: bei hoher, kontinuierlicher Auslastung oft günstiger als API-Nutzung; CAPEX und OPEX flexibel kombinierbar | Token- oder Request-basiertes Pay-per-Use: besonders geeignet für geringe bis mittlere Nutzung, Experimente und volatile Lasten |

| Time-to-Market | Initialer Setup-Aufwand (Provisionierung, MLOps, Integrationen, Security-Konzept), Amortisierung bei langfristigen, stabilen Workloads | Schneller Einstieg per API-Key; Integrationen in bestehende Anwendungen häufig innerhalb weniger Tage bis Wochen umsetzbar |

| Performance & Latenz | Latenz und Durchsatz durch Netzwerknähe, dedizierte Hardware und optimierte Serving-Stacks gezielt steuerbar | Globale Skalierung out of the box; Latenz abhängig von Region, Netzwerkanbindung und Provider-Architektur |

| Sicherheit | Volle Integration in eigenes Security-, Netzwerk- und Identity-Ökosystem (z.B. VPN, Zero Trust, SSO, SIEM, eigene KMS) | Sicherheitsmechanismen des Providers; Einbindung in eigene Security-Prozesse eingeschränkt möglich |

| Verfügbarkeit & Skalierung | Skalierung über dedizierte Ressourcen, Kapazitätsplanung und ggf. automatisierte Cluster-Skalierung | Hohe Verfügbarkeit und automatische Skalierung vom Provider, inklusive globalen Failover-Strategien |

| Typische Zielgruppen | Regulierter Mittelstand, Enterprise, Public Sector; sensible Workloads, interne Wissensportale, Compliance-kritische Prozesse | Startups, kleinere Teams, Produktorganisationen mit schnellen Iterationen; generische Use Cases, Experimente und volatile Nutzungsmuster |

| Beispiel-Use-Cases | Interne Copilots mit proprietären Daten, Fachanwendungen mit Prüfpflicht, automatisierte Dokumenten- oder Vertragsanalysen im regulierten Umfeld | KI-gestützte Chatbots, Content- und Code-Generierung, Ideation-Tools und produktnahe Features mit schnell wechselnden Anforderungen |

LLM Server Hosting in der Private Cloud

Beim LLM Server Hosting in der Private Cloud laufen die Modelle auf dedizierten Ressourcen in einer kontrollierten Umgebung, etwa im eigenen Rechenzentrum oder bei einem europäischen Cloud- oder Hosting-Provider. Unternehmen bestimmen selbst, welche Modelle (z.B. LLaMA, Mistral, DeepSeek) eingesetzt werden, wie diese konfiguriert und abgesichert sind und welche Daten das System überhaupt verarbeiten darf.

Vorteile privater LLM Server in der Private Cloud:

LLM Server Hosting über öffentliche Cloud-APIs

Bei öffentlichen Cloud-APIs betreiben Anbieter wie OpenAI, Hyperscaler oder spezialisierte Plattformen die LLM-Server vollständig in ihrer Infrastruktur; Zugriff erfolgt über eine Internet-API mit nutzungsbasierter Abrechnung. Die Provider übernehmen Skalierung, Updates, Security-Patching und in vielen Fällen auch zusätzliche Funktionen wie Monitoring, Guardrails oder Content-Filter.

Vorteile öffentlicher Cloud-APIs:

Die 6 relevantesten Public LLM-APIs

Zu den relevantesten öffentlichen LLM-APIs für Unternehmenseinsätze zählen aktuell vor allem folgende Plattformen:

Für wen eignet sich welches Modell?

Private Cloud

Private LLM-Server in der Private Cloud eignen sich besonders für Unternehmen mit hohem Schutzbedarf und klar planbarem LLM-Einsatz:

öffentliche Cloud-APIs

Öffentliche Cloud-APIs sind ideal für Organisationen, die schnell starten und ohne eigene Infrastruktur mit LLMs arbeiten wollen:

Weiterführende Links

Casoon: Enterprise-LLM-Markt 2024–2025: Wie Anthropic OpenAI überholte, https://insights.casoon.de/artikel/enterprise-llm-markt-2024-2025-anthropic-openai/

Global Market Insights: Größe des Enterprise-LLM-Markts – Nach Modell, Nach Komponente, Nach Bereitstellungsmodus, Nach Unternehmensgröße, Nach Endverwendung, Wachstumsprognose, 2025 – 2034 https://www.gminsights.com/de/industry-analysis/enterprise-llm-market

Fortune Business Insights: Hardware- und Software-IT-Dienste / Enterprise LLM-Markt: https://www.fortunebusinessinsights.com/de/enterprise-llm-markt-114178

Ein starkes LLM-Setup ist kein Selbstzweck, sondern ein Hebel für echte Wettbewerbsvorteile. Du triffst mit der Wahl zwischen privaten LLM-Servern in der Private Cloud und öffentlichen Cloud-APIs eine Grundsatzentscheidung: Wie viel Kontrolle, Datensouveränität und Kostenstabilität brauchst du – und wie viel Geschwindigkeit, Flexibilität und Experimentierfreiheit ist dir wichtig. Wenn du diese Fragen klar beantwortest, wird LLM Server Hosting vom Experiment zur tragfähigen Plattform, auf der deine Teams Wissen schneller nutzbar machen, Prozesse intelligent automatisieren und digitale Produkte spürbar beschleunigen. Weitere Infos findest du unter:

Das könnte dich auch interessieren

-

SEO-Relaunch: Website Relaunch ohne Ranking Verlust – Checkliste

Ein Website Relaunch ist Chance und Risiko zugleich: Ohne klares SEO-Konzept können Rankings, Backlinks und Anfragen einbrechen – trotz neuem Design. Ein strukturierter SEO-Relaunch sorgt dafür, dass du erst deine heutigen Erfolge sicherst und dann die neue Struktur, Weiterleitungen und Tests so planst, dass dein Relaunch zum kontrollierten Upgrade deiner Sichtbarkeit wird.

-

LLMs.txt auf WordPress: So optimierst du deine Website für ChatGPT & KI-Suche

Die LLMs-Datei in WordPress ist der Schlüssel für moderne SEO: Mit gezielter Ausspielung relevanter Inhalte per llms.txt Datei und unterstützenden Plugins wie Yoast, Rank Math oder Website LLMs.txt lässt sich die KI-Sichtbarkeit einer Website messbar steigern.

-

Quellenangaben & Schema.org für WordPress SEO

Externe Quellen WordPress SEO sind entscheidend, um Inhalte für Nutzer und KI-Suchmaschinen wie ChatGPT, Google Copilot oder Perplexity transparent und vertrauenswürdig zu machen. Durch strukturierte Daten mit dem Schema.org citation WordPress-Markup kannst du den Ursprung deiner Inhalte deutlich machen und so deine Sichtbarkeit erhöhen. Dieser Beitrag zeigt dir, wie du Quellen richtig angibst, mit Schema.org auszeichnest und FAQ-/HowTo-Schema für noch bessere Nutzerantworten einsetzt.