Was sind KI-Crawler?

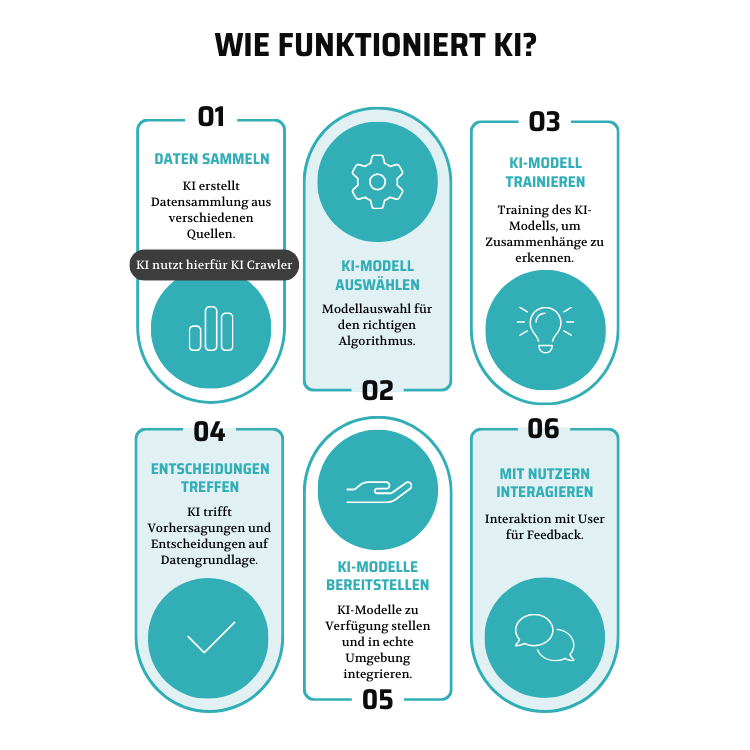

Wie funktionieren KI-Crawler?

Unterscheidung zwischen KI-Crawler und Webcrawler

| KI-Crawler | Webcrawler | |

|---|---|---|

| Definition | Webcrawler mit künstlicher Intelligenz und maschinellem Lernen | Allgemeine Webcrawler, die das Web durchsuchen und Inhalte speichern |

| Technologie | KI-Algorithmen | Einfache Algorithmen |

| Medienformate | Erkennen Texte, Bilder und Videos | Fokus auf Texte |

| Interaktivität | Interagieren mit dynamischen Inhalten wie z.B. Buttons auf Websites | Folgen strikt den vorgegebenen Anweisungen und sind weniger flexibel |

| Anwendungen | Suchmaschinen, Chatbots, Assistenten | Hauptsächlich Suchmaschinen, Preisvergleiche und Datenanalyse |

| Datenverarbeitung | Komplexes Analysieren und Interpretieren der Daten | Einfaches Sammeln und Speichern von Daten |

Vorteile von KI-Crawler?

- Training von KI-Modellen: KI-Crawler können große Mengen an Trainingsdaten sammeln, sodass Nutzer ihre eigenen KI-Modelle gezielt trainieren und verbessern können.

- Präzisere Suchergebnisse: KI-Crawler verstehen den Kontext von Suchanfragen besser und liefern dadurch relevantere und genauere Ergebnisse.

- Verbesserter Zugang zu aktuellen Informationen: Durch die Fähigkeit, dynamische Inhalte zu erfassen, erhalten Nutzer Zugang zu den neuesten und aktuellsten Informationen.

- Vielfalt an Inhalten: KI-Crawler können verschiedene Medienformate wie Text, Bilder und Videos erkennen, was zu vielfältigeren Suchergebnissen führt.

- Personalisierte Erfahrungen: Durch die Analyse von Nutzerdaten können KI-Crawler die Inhalte an die individuellen Bedürfnisse und Interessen der Nutzer anpassen.

- Effiziente Informationssuche: Die Nutzung von KI-Technologien ermöglicht eine schnellere und effizientere Suche nach Informationen.

- Unterstützung wissenschaftlicher Forschung: KI-Crawler helfen Forschern, große Mengen an Daten systematisch zu sammeln und zu analysieren, was die Entdeckung neuer Erkenntnisse und Trends erleichtert.